CUDA与CUDNN安装教程

CUDA与CUDNN安装教程(torch.cuda.is_available() 的返回值为true)

前言

在跑训练算法的时候,发现算法用的一直都是CPU去跑,导致于CPU被占满了,一直发热,所以决定去解决torch.cuda.is_available() 的返回值为false这个问题,刚好我的电脑有独立显卡GTX1650

解决办法

GPT去寻找解决办法

- 可能是没有安装CUDAtoolkit,和CUDNN

- 安装的CUDAtoolkit与

pytorch-gpu版本不一样 - 没有独立显卡

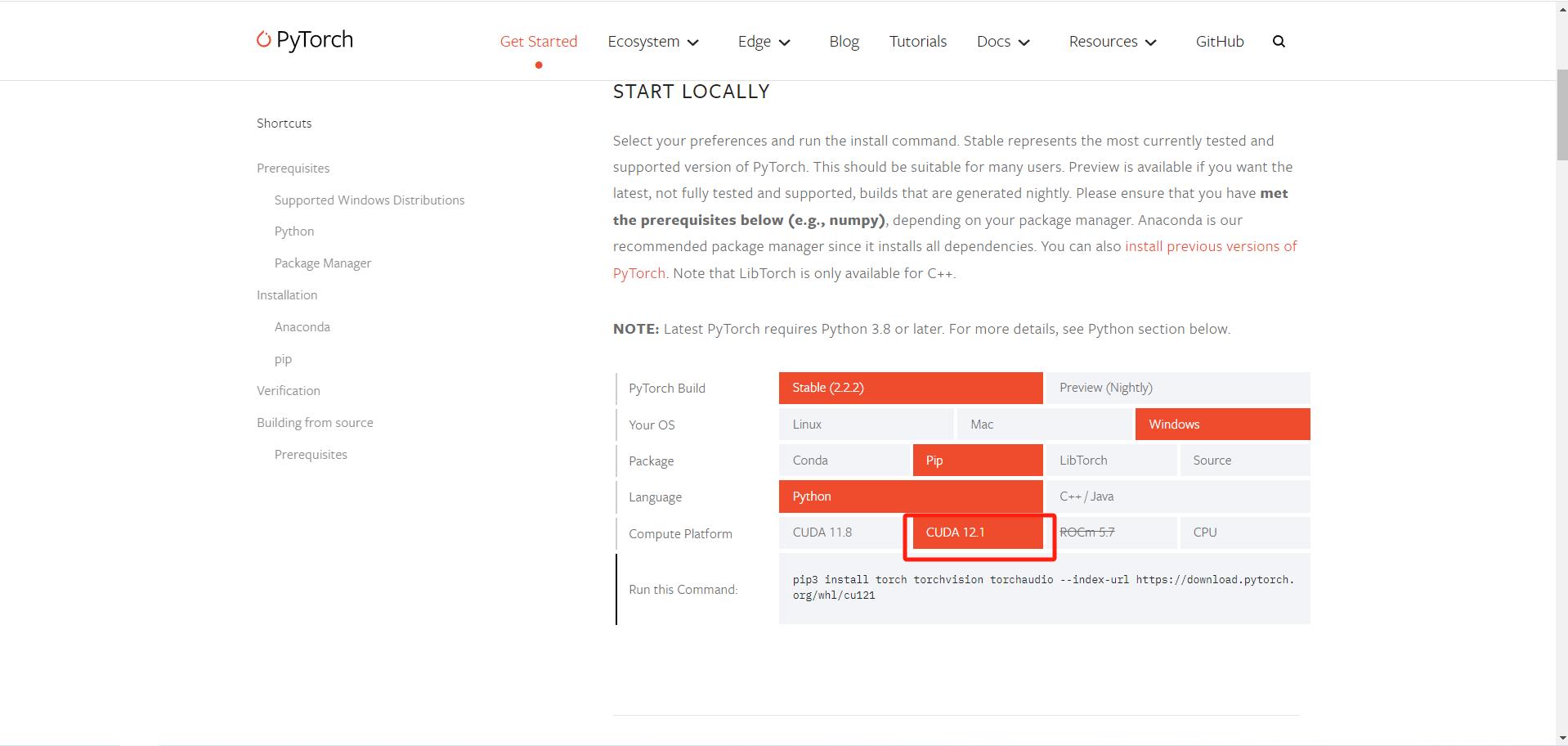

首先独显我是有的,但是我确实没有独立安装CUDAtoolkit和CUDNN,可能是这个原因,第二个原因也说可能版本不对,所以安装的时候得注意版本,我们先去看看我们的版本的pytorch支持的CUDAtoolkit是多少,先去官网查询一下,https://pytorch.org/get-started/locally/

发现最高支持的CUDA版本为12.1

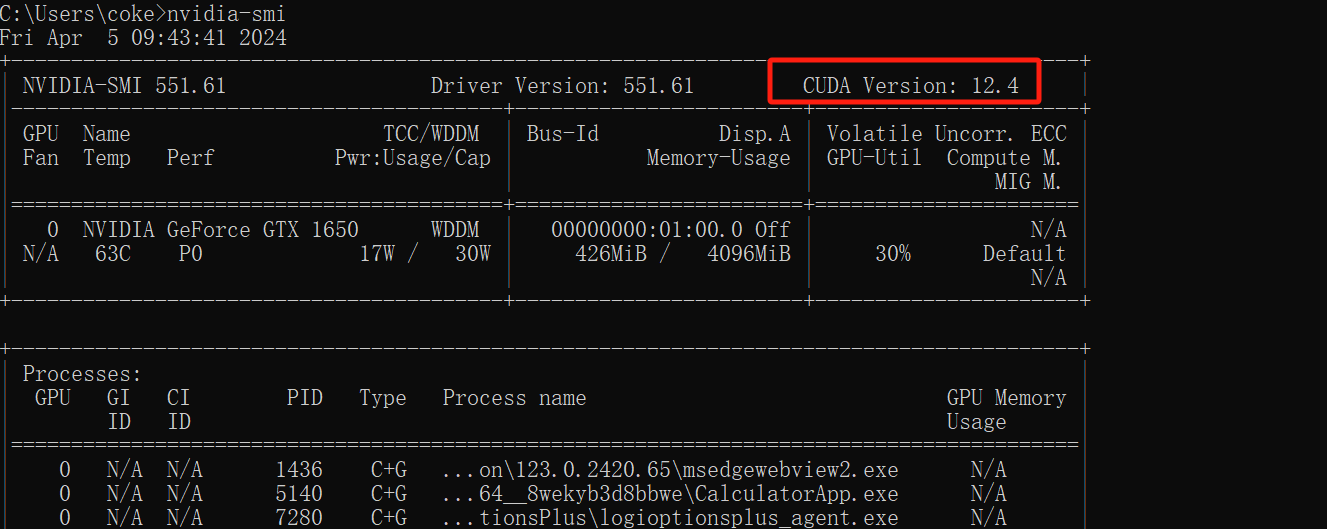

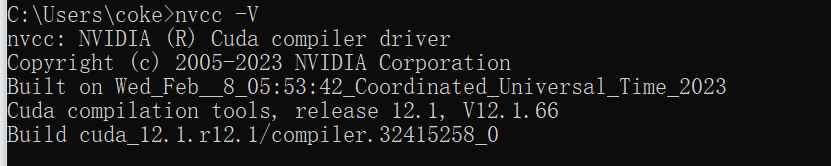

查看一下本地CUDA的版本

命令为nvidia-smi

发现本地的CUDA版本为12.4,于是我们只能安装12.1的CUDAtoolkit了

安装CUDAtoolkit

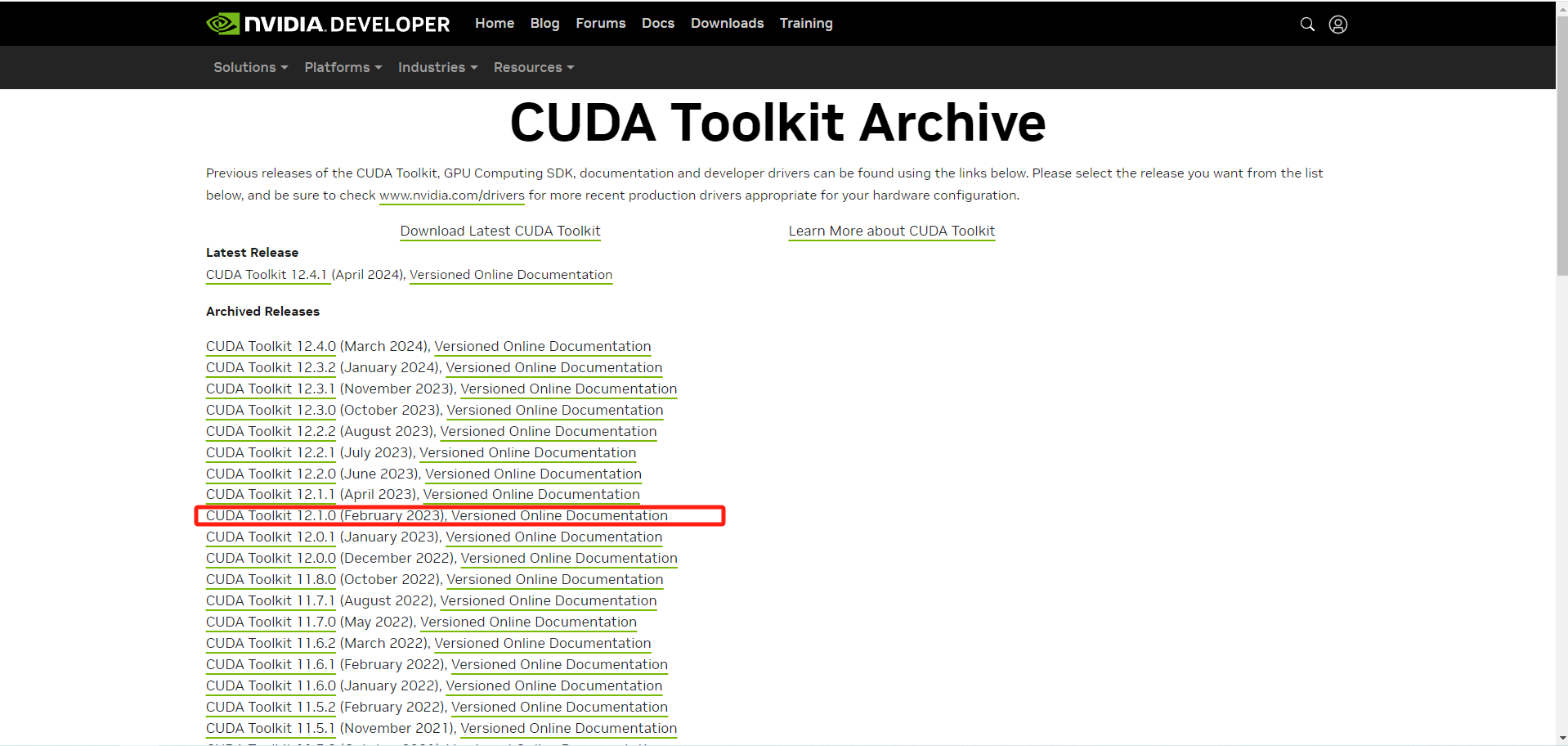

cudatoolkit网址

https://developer.nvidia.com/cuda-toolkit-archive

点进去,按照如下配置选择,然后点击下载:

此处我们使用离线安装方法,下载exe可执行文件完成安装。

cuda安装,全部默认即可,如果没有安装过的话。安装过了就只安装CUDA

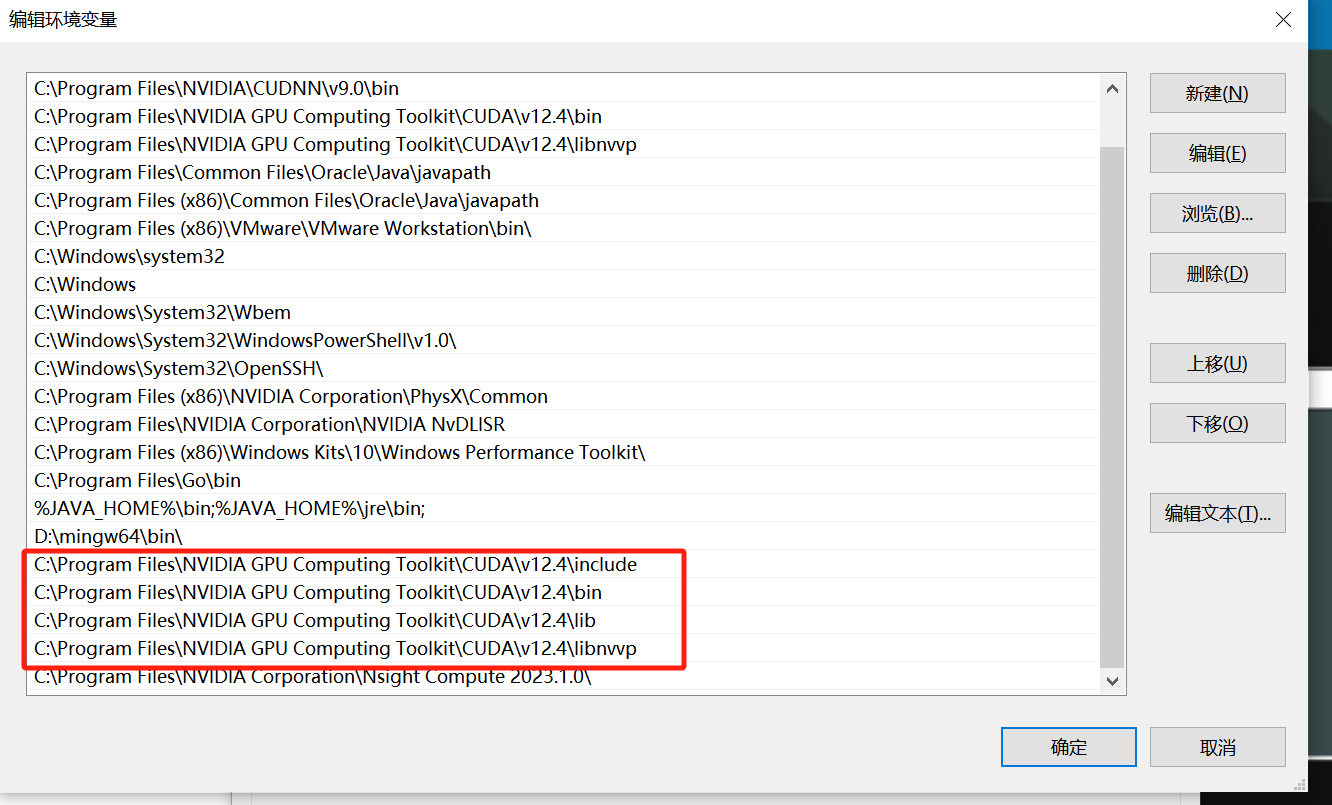

然后去添加环境变量

验证CUDA是否安装成功:

win+R键运行cmd,输入nvcc –version 即可查看版本号;

set cuda,可以查看 CUDA 设置的环境变量。

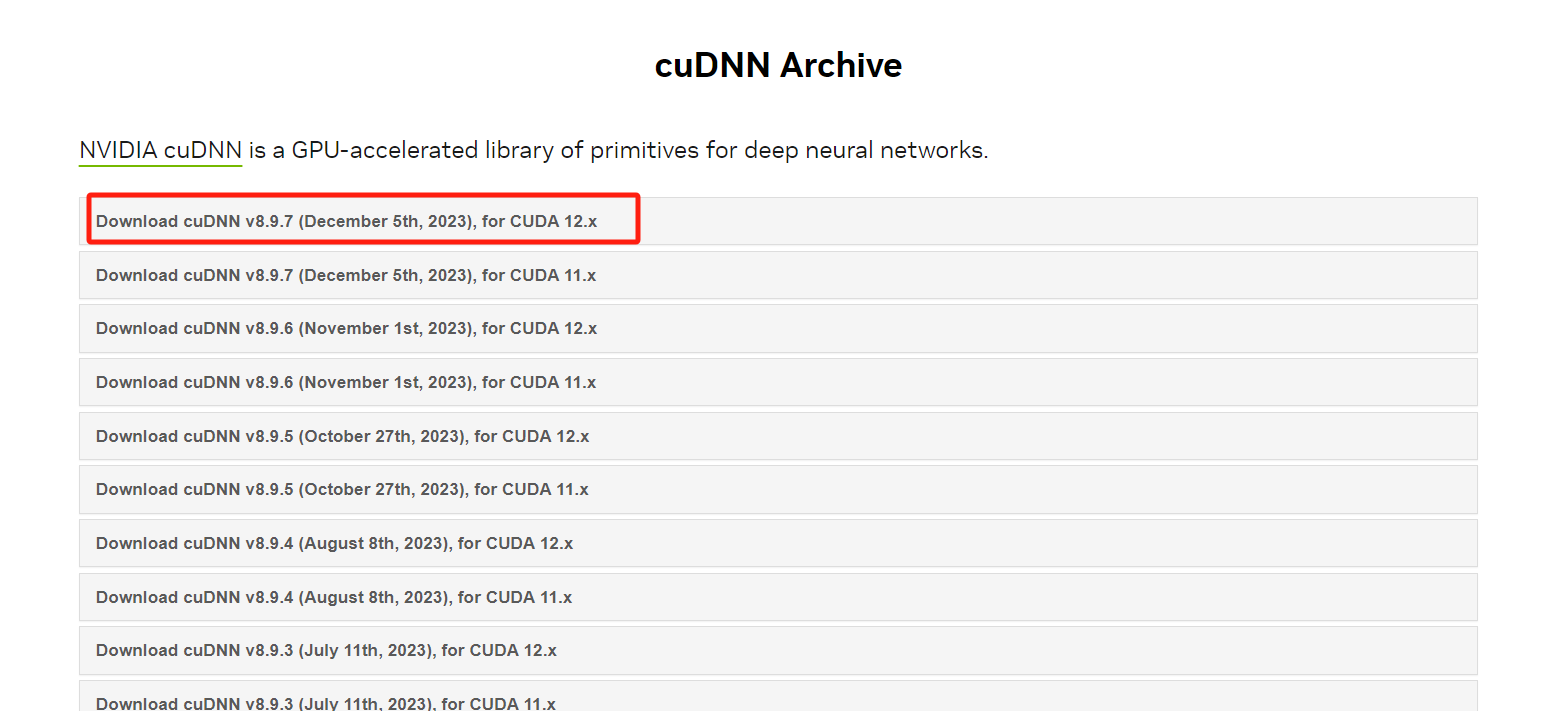

CUDNN下载及安装

CUDNN下载

CUDNN地址如下,不过要注意的是,我们需要注册一个账号,才可以进入到下载界面。大家可以放心注册的。

https://developer.nvidia.com/rdp/cudnn-archive

我们安装一下12.x版本的就行

下载结果是一个安装包,安装完后打开安装的那个目录,有三个文件夹,把三个文件夹拷贝到cuda的安装目录下。

CUDNN 其实是 CUDA 的一个补丁,专为深度学习运算进行优化的。

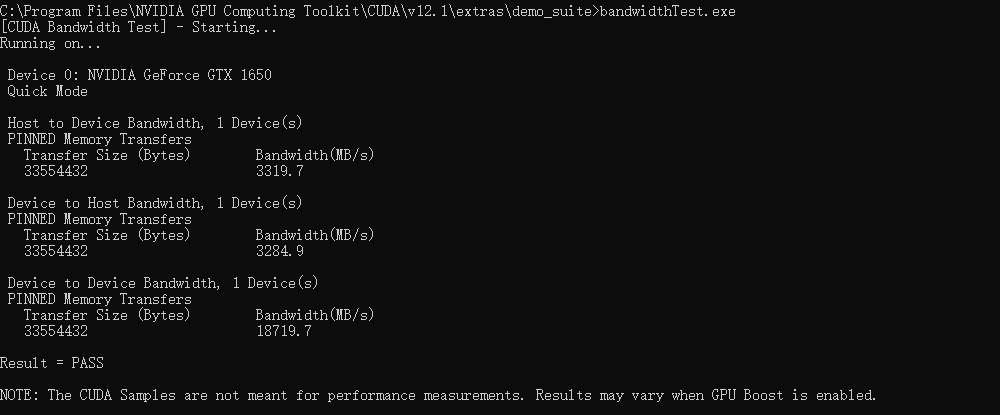

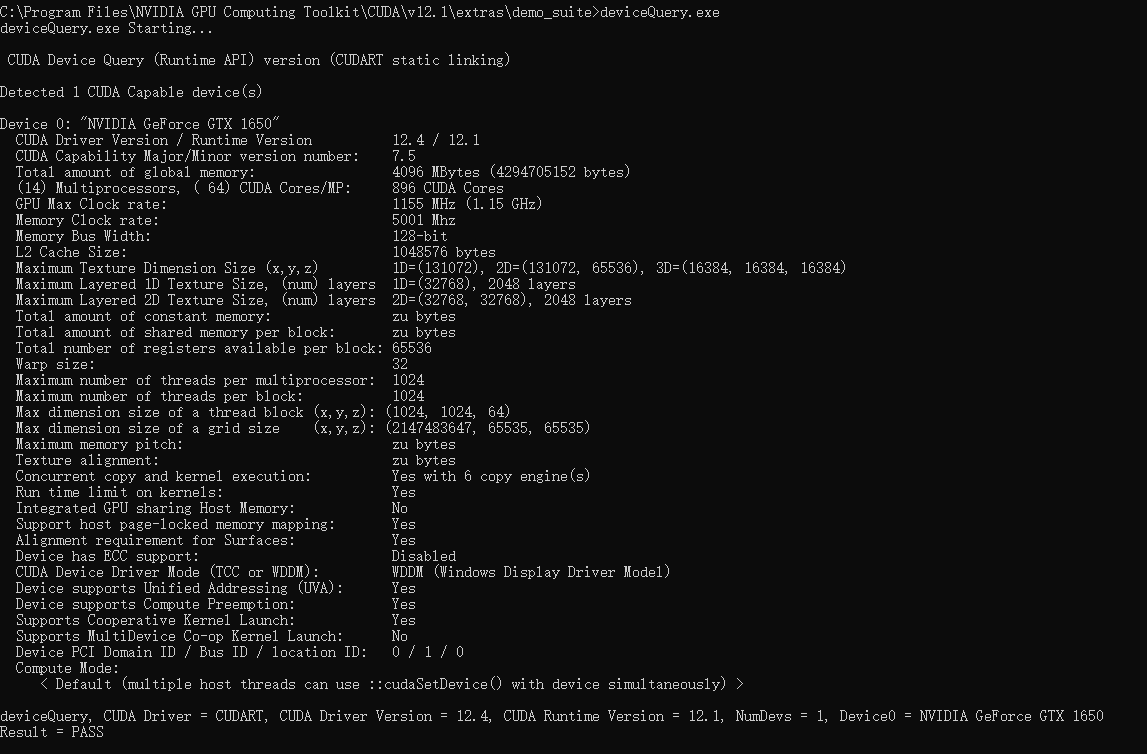

验证配置是否成功

配置完成后,我们可以验证是否配置成功,主要使用CUDA内置的deviceQuery.exe 和 bandwidthTest.exe:

首先win+R启动cmd,cd到安装目录下的 …\extras\demo_suite,然后分别执行bandwidthTest.exe和deviceQuery.exe(进到目录后需要直接输“bandwidthTest.exe”和“deviceQuery.exe”),得到下图:

正常输出就是安装成功了